サーバーとストレージの関係 DAS/SAN/NASの利点、欠点

前回は、サーバーの進化とフラッシュメモリがどのように使われているのかを解説しました。第4回では、サーバーとストレージの関係やフラッシュメモリの役割について、より詳細に解説します。最新のデータセンターに使われているソフトウェア・デファインド・ストレージに進化するまでの歴史をたどりながら、どうしてこうした進化が必要になってきたのかを考察していきましょう。

安価なサーバーとオープンソースソフトウェアの隆盛

近年、複数ベンダーのハードウェアやソフトウェアを組み合わせ、コンピュータのシステムを構築することが増えてきました。インテルの高速なCPUや、安価で大容量なメモリチップやハードディスクといったような部品をSASやSATAなどのインタフェースと組み合わせることによって、サーバーのハードウェアは安価でありながら高速かつ大容量になります。またソフトウェアの面でも、商用のサーバー向けOSだけでなく、オープンソースのLinuxが主流になり、新興のベンチャー企業でもエンタープライズ向けのソリューションを提供できるようになりました。

この例としてよく取り上げられるのが、FacebookやGoogle、Amazonといった新興のインターネット企業が運営しているデータセンターです。これらの大規模なデータセンターで導入されているサーバーおよびそこで稼働しているソフトウェアは、従来のサーバーベンダーのソリューションではなく、ODM(Original Design Manufacturing)メーカーに製造委託したサーバーを採用しているのです。このホワイトボックスサーバーは、インテルのCPUと安価な部品をもとに組み上げられたx86ベースのサーバーと、オープンソースソフトウェアで構成されており、大きな注目を集めています。

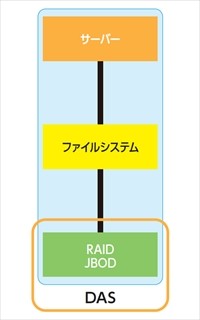

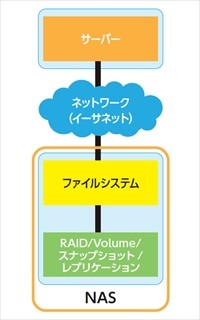

そのような環境でサーバーとストレージがどのように進化してきたのか、外部接続型のストレージの接続形態である「DAS(Direct Attached Storage)」、「SAN(Storage Area Network)」、「NAS(Network Attached Storage)」を例にあげて歴史をたどっていきます。

サーバーとストレージをダイレクトに接続:DAS(Direct Attached Storage)

DASはその名前のとおり、サーバーとストレージがSAS(Serial Attached SCSI)などのインタフェースで直接接続する形態です。スキルや知識がなくても簡単に導入できるという手軽さや、コストが比較的安いことが利点である反面、複数のサーバーから共有することが難しいため乱立してストレージの利用効率が悪かったり、運用負荷が高くなるデメリットがあります。

専用ネットワークを使った共有ストレージ:SAN(Storage Area Network Storage)

DASを進化させて、高性能と大容量を追求したのがSANストレージです。サーバーとストレージ間の通信を高速化する光ファイバーケーブルで接続しています。この接続形式では、ホストとなるサーバーには光ファイバーを接続するためのインタフェースHBA(Host Bus Adapter)を搭載し、光ファイバーで接続されるストレージアレイの手前には複数の光ファイバーを束ねるファイバーチャネルスイッチが必要になり、そのスイッチにストレージアレイが接続される構成となります。

サーバーとストレージが直接接続されていたDASとは異なり、SANストレージではストレージがサーバーと分離されることで、より大きな容量と高性能、バックアップや障害対応などの管理機能をストレージ側で搭載することが可能になりました。専用のファイバーチャネルではなく汎用のイーサーネットを使って接続を行う製品もあります。ファイバーチャネルを利用するSANを「FC-SAN」、イーサーネットを利用するSANを「iSCSI」などと呼びます。

SANストレージはブロックストレージとして利用され、ディスクを束ねたRAIDからLUN(Logical Unit Number)を切り出し、ストレージアレイへのアクセスは論理的に分割されたブロック単位で行われます。サーバーはそのLUNを自分のローカルディスクとして認識し、ファイルシステムをフォーマットしてデータを格納します。

イーサーネットを使ってファイルアクセスするストレージ:NAS(Network Attached Storage)

メインフレームの時代から存在するブロックストレージとは違い、NFSやSMB(CIFS)などのファイル共有プロトコルを用いてネットワーク上の共有ストレージにファイルアクセスするのがNASです。SANストレージとは異なり、サーバーとストレージアレイの接続にLANで利用されるイーサーネットを利用するため、SANよりも容易に導入できることがメリットのひとつです。イーサネットにおける転送速度の進化はファイバーチャネルを凌駕しており、10Gbpsの普及が進み、40Gbps、100Gbpsでのサーバーとストレージ間の接続も登場し始めています。

NASはLUNを提供するだけのSANストレージとは違い、ファイルシステムをストレージ側で実装しています。そのことが、仮想化やフラッシュストレージに対して大きな効果をもたらします。

仮想化はその名の通り、サーバーやデスクトップが仮想化され、ひとつのファイルにまとまっています。NANDフラッシュメモリは、前述したハードディスクのセクターサイズと違い、NANDフラッシュ特有のページサイズ、ブロックサイズといったデータの格納単位を意識する必要があります。

仮想環境専用フラッシュストレージであるTintriなどは、ファイルシステムを仮想マシンファイルに最適化し、ブロックアクセスするSANなどのストレージでは構造上実現できない仮想マシン単位のストレージ管理を実現しています。また、ひとつの筐体でSANストレージとNASの両方を提供するユニファイドストレージもあります。

SANストレージやNAS、ユニファイドストレージでは、ストレージデバイスとしてハードディスクだけではなくSSDなどのNANDフラッシュメモリを使った製品があります。特に、近年ではフラッシュメモリの価格が下がってきているため、多くのベンダーが低価格層にはハードディスクとフラッシュメモリのハイブリッドを、高性能が求められるエンタープライズ向けにはオールフラッシュのストレージを用意しています。

ソフトウェアだけで並列分散ストレージを実現:SDS(Software Defined Storage)

冒頭で、GoogleやFacebook、Amazonなどのデータセンターでは、x86ベースのサーバーとオープンソースソフトウェアでサーバーとストレージを実現していると紹介しました。x86ベースのサーバーを、アプリケーションを稼働させるためのコンピュータとして使うだけでなく、ストレージのコントローラーとして使用し、それを実現するためにハードウェアに何かを加えるのではなく、ソフトウェアだけで実現する―― これが「ソフトウェア・デファインド・ストレージ」(以下、SDS)と呼ばれる実装方法です。

サーバーそのものは、インテルのCPUにメモリやSSD、HDD、イーサーネットなどを備えた安価なハードウェアです。そこにオープンソースソフトウェアのOSや分散処理を実現するソフトウェアを適用し、巨大なクラスタ構成によるストレージプールを構成します。

では、今後ストレージはSDSに傾倒し、SANストレージやNASなどの外部接続型ストレージは市場が縮小していくのでしょうか。

SDSなどオープンなハードウェアとソフトウェアで構成される大規模なクラウドサービスでは、しばしばサービスの停止、データの消失、情報漏洩が発生してニュースとして取り上げられます。時には「クラウド離れ」なる言葉も出てきています。

柔軟な構成がメリットのSDSも、きちんと運用管理するためには、”決め打ち”構成で定めらたx86サーバーとSSD,HDDしか選択できないケースもあります。一方、従来のSAN,NASなどの外部接続型ストレージも、SDSと変わらずx86ベースのアーキテクチャで汎用部品を用いることが多くあり、その上でソフトウェアを実行しています。

外部接続型ストレージが培ってきた、急な電源停止やフェイルオーバーでもデータを消失させないアーキテクチャが改めて見直される向きもあり、データを格納するストレージは、性能、容量、重要度などの要件に応じて適材を適所に使うことが求められはじめていると言えるでしょう。

※本ページは、『マイナビニュース』へ掲載された記事広告を転載しています。